经济学家的星战:一场掉节操的游戏?

经济学家的星战:一场掉节操的游戏?

一颗两颗三颗星

如果你碰巧有个经济学家朋友,而且热(zuo)心(si)地询问过他最近的研究进展如何,那你多半听到过这样的回答:“唉,做不出来啊。” 如果你碰巧又对他们这个行当有所了解,那你就心知肚明,这句回答背后的潜台词是:“老子觉得自己这个 idea 牛 X 爆了,结果怎么就他喵的弄不显著呢!?”

“显著” 二字,是多少学者的心头所痛。伴随着计量技术的飞速发展,主流经济学期刊对于实证结果的要求越来越高,而统计显著性,几乎成为了实证文章得到发表的先决条件。

在论文的数据分析表格里,显著性用小星星表示。一般来说,一颗星代表在 10% 水平上显著,两颗星 5%,三颗星 1%;也有学科惯例是一颗星 5%,两颗星 1%,三颗星 0.1%。这些星星差不多是所有实证经济学家梦寐以求的目标。随便翻开一篇发表在主流经济学期刊上的实证论文,跳到结果部分,最先跃入你眼帘的,就是数不清的星星,一颗,两颗,三颗……

好东西太多了也会惹人厌烦,星星亦是如此。学界一直有人抱怨:我们是不是进入了一个星星 “通货膨胀” 的时代?一个关于 MIT经济学家达隆·阿西莫格鲁的著名笑话是:他的结果太显著,电脑里的星星都不够用了(见Acemoglu Facts,一个以黑阿西莫格鲁为主要事业的网站)。

太多的星星真的是一件坏事吗?毕竟统计显著性标志着结果的可信程度,主流期刊偏好可信程度高的研究,似乎也无可厚非。然而,真正令人担心的是,期刊对于星星的重视,可能会激励学者在论文中只提及那些统计显著的结果,甚至会利用一些统计技巧,让原本不显著的结果变得显著。如果真是这样,我们恐怕就不得不为经济学家朋友们的节操感到隐隐的担忧了。

一张令人吃惊的图

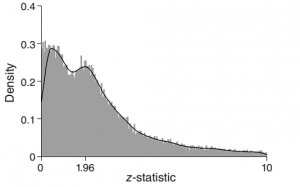

在最新一期《美国经济学杂志:应用经济学》上,四位学者发表了一篇以《星战:实证研究的反击》(Star Wars: The Empirics Strike Back)为题的论文,对上述可能性进行了考察。他们收集了 2005 到 2011 年间,发表于三大顶级经济学期刊:《美国经济评论》(American Economic Review)、《经济学季刊》(Quarterly Journal of Economics)和《政治经济学杂志》(Journal of Political Economy)上的共计 5 万多个统计检验及其作者的个人资料作为数据来源,并绘制出了这些检验的 z 统计量(即标准化之后的 p 值)分布图。

从上图可以看到,这些统计检验的 z 值呈现出了令人吃惊的双峰分布:有大量检验得出了不显著的结果;随着其 z 值增加,得到发表的检验数量逐渐减少;但在 z 值达到 1.96,即 5% 显著性水平这一门槛附近时,又开始有越来越多的检验被发表在三大经济学顶级刊物上。在考虑了四舍五入导致的误差,并对包含检验数目不同的论文进行了权重调整之后,我们仍然可以观察到上述的现象。

按照学界的惯例,5% 及更高的显著性水平被视为较为合意的结果。因此,z 值分布在 1.96 附近的反常,不由让人怀疑这些检验结果遭遇了人为的操纵。不过,会不会是经济学期刊对于显著结果的偏爱才导致了双峰分布的出现呢?四位研究者指出,如果真是这样,那我们只会发现得到发表的检验数量随着 z 值增加而不断上升,并不会观察到图中先下降再上升的趋势。

10-20% 的结果有人为操纵迹象

为了精确估计期刊偏好所产生的影响,研究者们假定,一篇实证文章能否被期刊接受,取决于两方面因素:结果的统计显著性,以及其他方面(题材的重要程度、方法的原创性等等)的质量。在其他方面的质量相同时,期刊会愿意发表结果更显著的论文;如果不存在人为因素影响,那么论文在其他方面是否优秀的概率,应该与其结果的统计显著性互相独立。在此基础上,给定全部投稿论文的先验质量,我们就能估算出理想状态下,期刊上统计检验的 z 值应该表现出来的分布。先前我们观察到的实际分布减去这一理想分布之后剩下的残差,就是统计检验的 z 值变化中,无法由期刊偏好解释的部分。

研究者们发现,上述残差在 z 值达到 1.96 之前几乎为零,在那之后则迅速上升。对于不同的投稿论文先验质量分布和不同的研究子领域,这一结果都是稳健的。以不显著结果作为主要贡献的论文由于数量太少,也不可能是造成双峰分布的原因。

更为有趣的是,那些未用星星或粗体字标识显著结果的论文——可能意味着作者不太在乎结果的统计显著性——表现出了更小的残差。如果论文是基于某个理论模型或者随机实验方法,其残差会明显低于平均水平;稳健性检验的结果则往往会有高于主要检验的残差。

最后,相比于青年研究人员,较为资深、拥有终身教职的学者发表的论文残差也会更小一些。总的来说,在那些研究者有激励,或者更容易操纵统计结果的情况下,我们会更频繁地观察到 z 值不能被期刊偏好解释的异常变动。研究者们的计算显示,那些有人为操纵迹象的结果,占了全部边际显著(marginally significant,即 z 值刚刚超过 1.96)检验的 10%-20%。

社会科学家的节操还能坚挺多久?

当然,统计趋势并不能作为人为操纵确实存在的决定性证据。四位研究者所依赖的研究假设也远非无懈可击。然而,这一研究至少说明,人们对统计显著性通胀的批评,似乎不能仅仅看作空穴来风。去年政治学中出现的 Lacour 丑闻(见《图文详解:<科学>杂志论文数据造假现形记 》http://cnpolitics.org/2015/06/lacour/),以及心理学中重复经典实验的一再失败,迫使学者们开始思考这样的问题:我们得到的 “结论” 到底是对世界的真实认知,还是用统计学小把戏变出的障眼法?在统计显著性的诱惑面前,社会科学家们的节操还能坚挺多久?

幸运的是,在各个社科领域之中,总还有一些节操高于平均水平的成员,在不断地默默推动着本学科在严谨性方面的进步。本文反复提及的四位研究者本身都是经济学家,心理学中的重复实验也是由心理学家倡导发起,Lacour 丑闻也是由政治学家 David Broockman 最先揭发。为了限制对统计结果的人为操纵,新的方法和标准也在不断被学界提出。目前在经济学和政治学的主流期刊上,公布原始数据已经成了一个基本的发表要求。很多经济学家和政治学家甚至会主动公布实证研究使用的软件代码(比如无辜中枪的阿西莫格鲁老湿)。伯克利的经济学家 Ted Miguel 近年来不断和同事一起,倡导 “Pre-Analysis Plans” 的广泛应用,即在正式开始研究之前,学者先把既定的研究方案公布在网上,以避免事后修改初始目标或方法之类的事情出现。

由于学术界的竞争日益激烈,显著性发生通货膨胀其实并不算出人意料。但是,我们不应因此而动摇对经济学,甚至全部社会科学研究的信心。毕竟,有人为操纵嫌疑的结果总是少数。随着定量技术的进一步完善,大数据分析的逐渐普及,和学术研究透明化程度的不断提高,我们有理由期待,未来的实证研究可以带给人们更加客观、更加确定、更加严格的结果。

参考文献

- Brodeur, Abel, Mathias Lé, Marc Sangnier, and Yanos Zylberberg (2016). “Star Wars: The Empirics Strike Back.” American Economic Journal: Applied Economics, 8(1) . 1-32.

- Casey, Katherine, Rachel Glennerster, and Edward Miguel (2012). “Reshaping Institutions: Evidence on Aid Impacts Using a Preanalysis Plan*.” The Quarterly Journal of Economics 127.4 1755-1812.

- Masicampo, E. J., and Daniel R. Lalande (2012). “A peculiar prevalence of p values just below. 05.” The Quarterly Journal of Experimental Psychology 65.11. 2271-2279.

- Miguel, E., et al. (2014). “Promoting Transparency in Social Science Research.” Science 343.6166. 30-31.

文章版权归原作者所有。