如何阻止AI从您的自拍照中识别出您的脸? - iYouPort

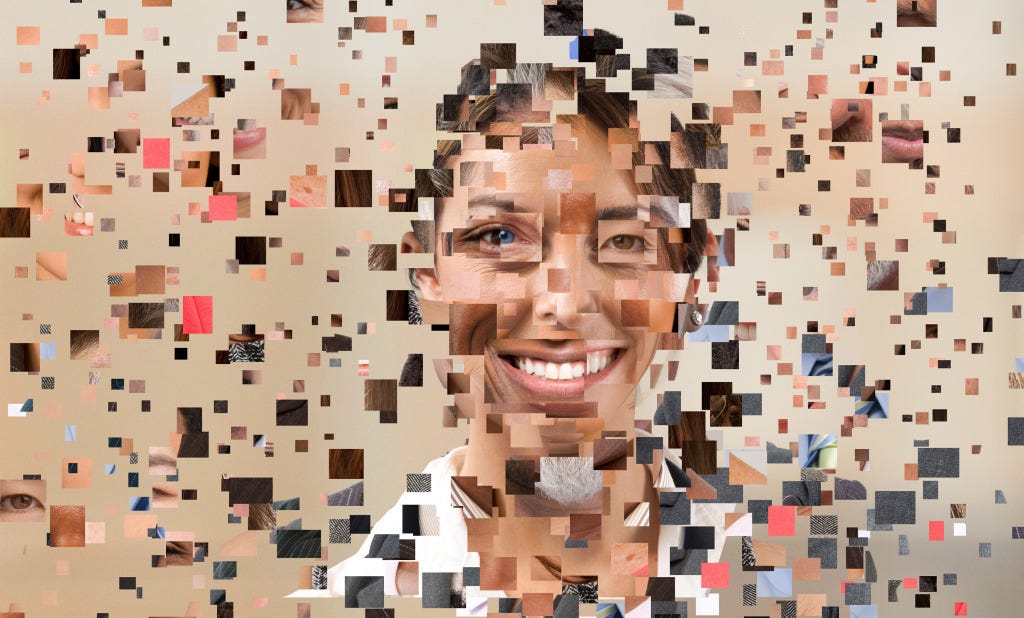

如何阻止AI从您的自拍照中识别出您的脸?

- 监视和反监视是一场持续的猫鼠游戏。如果你希望通过技术对抗技术的话,就尤其如此。选择加入持久战的公民反抗可能优势不大 ,因为你对抗的是几百亿美元的生物识别监视资本主义市场。但技术肯定是武器之一,虽然不是全部。

将个人照片上传到互联网上后,你就完全失去了控制权 。你不会知道还有谁能接触到这些照片、他们会用这些照片做什么、你的脸会被用来训练哪些机器学习算法?

比如最近的热议事件,Clearview 公司已经向执法机构提供了一个面部识别工具,该工具是根据从公开网络上搜罗的数百万人的照片训练出来的。但这只是个开始。这就是监视资本主义的工作方式。

关于 Clearview,如果您错过了《 只要一张照片,陌生人就可以找到您的一切私密信息 》

任何具有基本编码技能的人现在都可以开发面部识别软件,这意味着在从性骚扰和种族歧视到政治压迫和宗教迫害等等各个方面,滥用这项技术的潜力比以往不断迅速增大。

一些人工智能研究人员正在进行反击,开发出确保人工智能不能从个人数据中 “学习” 的方法。5月,在领先的人工智能会议ICLR上,有两个最新的成果被展示出来。

“我不喜欢人们从我这里拿走他们不应该拥有的东西”,芝加哥大学的艾米丽·温格说,她在去年夏天与她的同事开发了 第一批 这样做的工具之一,名为 Fawkes,“我猜很多人都有类似的想法”。

数据投毒并不新鲜。诸如删除公司掌握的关于你的数据,或故意用假的数据污染数据集等行为,可以使公司更难训练出准确的机器学习模型。但是,这些努力通常需要集体行动,有成千上万人一起参与,才能产生影响。而这些新技术的不同之处在于,它们对个人照片起作用。

澳大利亚迪肯大学的丹尼尔·马(Daniel Ma)说:“这项技术可以作为个人的一把钥匙来锁定自己的数据。这是人工智能时代保护人们数字权利的一个新的前线防御。”

隐藏在众目睽睽之下

大多数工具,包括 Fawkes,都采取了同样的基本方法。他们对图像进行微小的改动,这些改动用人眼很难发现,但却会让人工智能感到不安,导致它错误地识别照片中的人或物。这种技术非常接近于一种对抗性攻击,对输入数据的微小改动可以迫使深度学习模型犯大错。

如果您错过了《 机器学习训练集中的图像政治 》

给 Fawkes 一堆自拍照,它就会给图片添加像素级的干扰,从而阻止最先进的面部识别系统识别照片中的人。与以前的方法不同(例如涂抹对人工智能具有欺骗性的脸部涂料)Fawkes 可以使图像对人类来说显然是没有变化的。

温格和她的同事将他们的工具在几个广泛使用的商业面部识别系统上进行了测试,包括亚马逊的 AWS Rekognition、微软 Azure、和由中国公司 Megvii Technology 开发的 Face++。 在一个由50张图片组成的数据集的小实验中,Fawkes 对所有这些图片都100%有效 ,阻止了在经过篡改的人的照片上训练出的AI模型此后在新图片中识别同一个人的照片。篡改过的训练图像阻止了这些工具对这些人的脸部数据形成准确的表述。

Fawkes 已经在 该项目的网站上 被下载了近50万次。一位用户还建立了一个 在线版本 ,使人们更容易使用它(尽管温格不会为第三方使用该代码担保,并她警告说,“当别人在处理你的数据时,你不知道你的数据发生了什么”)。温格说,目前还没有一个手机应用程序,但随时都可能有人制作一个。

Fawkes 可能会阻止一个新的面部识别系统来识别你 — — 比如说下一个Clearview,但它不会破坏已经对你的未受保护的图像进行过训练的现有系统。简单说,如果你一直在社交媒体上传照片,而这些照片已经被纳入了人脸识别训练集,那么这个工具就不管用了。不过,这项技术一直在改进。温格认为,马里兰大学的 Valeriia Cherepanova 和她的同事开发的一个工具可能会解决这个问题。

该工具被称为 LowKey , 它在 Fawkes 的基础上进行了扩展,根据一种更强的对抗性攻击对图像进行干扰,这也骗过了预先训练的商用机器学习模型。与 Fawkes 一样, LowKey 也可以在线使用 。

Ma 和他的同事们增加了一个更大的转折点。他们的方法是将图像变成他们所谓的 “不可学习”的数据类型 ,有效地使人工智能完全忽略你的自拍。“我认为这很好”,温格说,“Fawkes 旨在训练一个模型来学习关于你的错误的数据,而这个工具则训练一个模型以便其无法学习关于你的任何信息。”

与 Fawkes 及其追随者不同,不可学习的数据不是基于对抗性攻击。Ma 的团队没有对图像引入迫使人工智能犯错的变化,而是添加了微小的变化,欺骗人工智能在训练期间忽略它。当稍后呈现图像时,它对其中内容的评估将不会比随机猜测更好。

“不可学习” 的数据可能证明比对抗性攻击更有效,因为它们不能被训练对抗。 人工智能看到的对抗性例子越多,它识别它们的能力就越强。但Ma和他的同事们则首先阻止了人工智能对图像的训练。

然而,温格感觉需要一场持续的战斗。她的团队最近注意到,微软 Azure 的面部识别服务不再能够被他们的工具修改的一些图像所欺骗。她说:“它突然以某种方式对我们生成的隐蔽图像变得强大起来。我们不知道发生了什么。”

微软可能改变了其算法,或者人工智能可能只是看到了太多使用 Fawkes 的人的图像,以至于它学会了识别它们。无论哪种情况,温格的团队 5月发布了对其工具的更新,以便再次对 Azure 起作用 。她说:“这是另一场猫捉老鼠的军备竞赛”。

对温格来说,这就是互联网的故事。她说:“像 Clearview 这样的公司正在利用他们认为是免费提供的数据来做他们想做的事”。

从长远来看,监管可能会有帮助,但这并不能阻止公司利用法律漏洞。她说:”在法律上可接受的东西和人们实际想要的东西之间总是会有脱节。像 Fawkes 这样的工具填补了这一空白。”

“我们可以给人们一些以前没有的权力”,她说。

文章版权归原作者所有。